英偉達(dá)發(fā)布超級(jí)芯片GH200反擊AMD

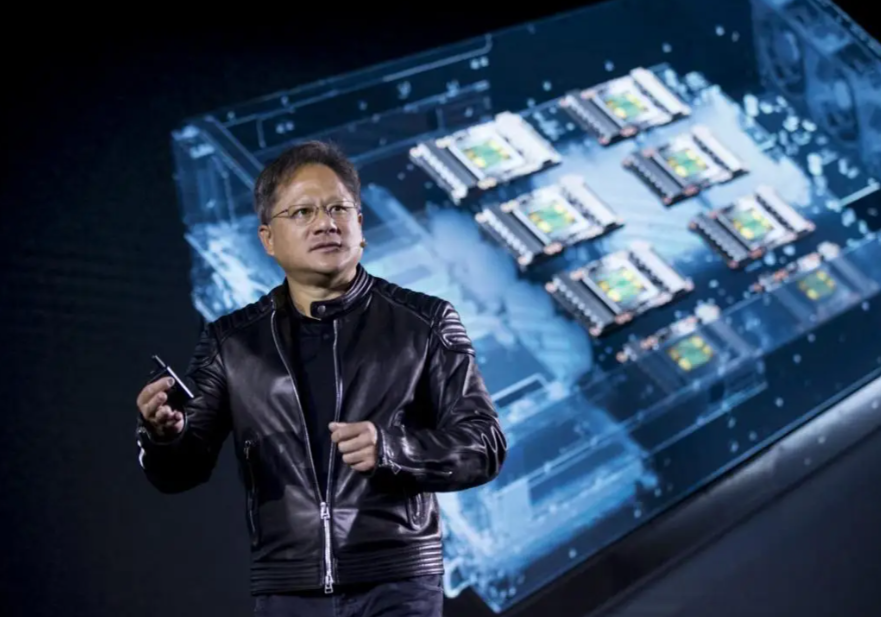

洛杉磯當(dāng)?shù)貢r(shí)間8月8日,在計(jì)算機(jī)圖形學(xué)頂會(huì)SIGGRAPH 2023現(xiàn)場(chǎng),英偉達(dá)再度釋放深夜“炸彈”,大模型專用芯片迎來(lái)升級(jí)版本。

英偉達(dá)在會(huì)上發(fā)布了新一代GH200 Grace Hopper平臺(tái),該平臺(tái)專為處理大語(yǔ)言模型、推薦系統(tǒng)、矢量數(shù)據(jù)庫(kù)等全球最復(fù)雜的生成式 AI 工作負(fù)載而構(gòu)建。

GH200 Grace Hopper平臺(tái)依托于搭載全球首款搭載HBM3e處理器的新型Grace Hopper超級(jí)芯片——GH200。HBM3e 內(nèi)存比當(dāng)前 HBM3 快 50%,可提供總計(jì) 10TB/s 的帶寬。這使得新平臺(tái)能夠運(yùn)行比上一版本大 3.5 倍的模型,同時(shí)憑借快 3 倍的內(nèi)存帶寬提升性能。

據(jù)介紹,該平臺(tái)采用雙配置,提供的內(nèi)存容量和帶寬比當(dāng)前產(chǎn)品分別增加了 3.5 倍和 3 倍,包括一個(gè)擁有 144 個(gè) Arm Neoverse 內(nèi)核、8 petaflops 的 AI 性能和 282GB 最新 HBM3e 內(nèi)存技術(shù)的單個(gè)服務(wù)器。

英偉達(dá)創(chuàng)始人兼首席執(zhí)行官黃仁勛表示:“為了滿足對(duì)生成式 AI 不斷激增的需求,數(shù)據(jù)中心需要能夠滿足特定需求的加速計(jì)算平臺(tái)。全新GH200 Grace Hopper 超級(jí)芯片平臺(tái)以出色的內(nèi)存技術(shù)和帶寬,提高了吞吐量,在不影響性能的情況下可連接多 GPU 以整合性能,并且具有可以輕松部署到整個(gè)數(shù)據(jù)中心的服務(wù)器設(shè)計(jì)。”

據(jù)英偉達(dá)公布信息,新平臺(tái)可以通過(guò) NVIDIA NVLink? 與其他超級(jí)芯片連接,使它們能夠協(xié)同工作,從而部署當(dāng)下大型生成式 AI 模型。這種高速、一致性技術(shù)使 GPU 可以完全訪問(wèn) CPU 內(nèi)存,在雙配置中可提供總計(jì) 1.2TB 的快速內(nèi)存。

值得注意的是,新平臺(tái)采用的新款超級(jí)芯片GH200與此前發(fā)布的H100相比,二者使用同樣的GPU,但GH200將同時(shí)配備高達(dá)141G的內(nèi)存和72核ARM中央處理器,每秒5TB帶寬,內(nèi)存增加了1.7倍,帶寬增加了1.5倍。

英偉達(dá)稱,GH200已于 5 月全面投產(chǎn),基于GH200 Grace Hopper平臺(tái)的新系統(tǒng)將于2024年第二季度交付。

新平臺(tái)和芯片的加持,也讓大模型訓(xùn)練的成本得到有效降低。黃仁勛表示,一臺(tái)服務(wù)器可以同時(shí)裝載兩個(gè)GH200超級(jí)芯片,大型語(yǔ)言模型的推理成本將會(huì)大幅降低。據(jù)介紹,投資800萬(wàn)美元Grace Hopper,就相當(dāng)于8800個(gè)價(jià)值1億美元的x86 GPU,意味著成本降低12倍,能耗降低20倍。

為降低了啟動(dòng)企業(yè) AI 項(xiàng)目的復(fù)雜性,英偉達(dá)當(dāng)日還發(fā)布了英偉達(dá)AI Workbench。其能夠?yàn)殚_(kāi)發(fā)者提供一個(gè)統(tǒng)一、易用的工作空間,使他們有能力在個(gè)人電腦或工作站上快速創(chuàng)建、測(cè)試和微調(diào)生成式 AI 模型,然后將這些模型擴(kuò)展到幾乎所有數(shù)據(jù)中心、公有云或DGX Cloud。

AI Workbench通過(guò)一個(gè)在本地系統(tǒng)上運(yùn)行的簡(jiǎn)化界面訪問(wèn),開(kāi)發(fā)者可以使用自定義數(shù)據(jù)對(duì)來(lái)自 Hugging Face、GitHub 和 NVIDIA NGC? 等流行資源庫(kù)的模型進(jìn)行定制。然后,這些模型可以多個(gè)平臺(tái)之間輕松共享。

英偉達(dá)企業(yè)計(jì)算副總裁 Manuvir Das 表示:“全球各地的企業(yè)都在競(jìng)相尋找合適的基礎(chǔ)設(shè)施并構(gòu)建生成式 AI 模型和應(yīng)用。NVIDIA AI Workbench 為跨組織團(tuán)隊(duì)創(chuàng)建基于 AI 的應(yīng)用提供了一條簡(jiǎn)化的途徑,而這些應(yīng)用正日益成為現(xiàn)代商業(yè)的關(guān)鍵。”

此外,英偉達(dá)與 Hugging Face 宣布建立合作伙伴關(guān)系,為數(shù)百萬(wàn)開(kāi)發(fā)者提供生成式 AI 超級(jí)計(jì)算服務(wù),幫助他們構(gòu)建大語(yǔ)言模型(LLM)和其他高級(jí) AI 應(yīng)用。此次合作將使開(kāi)發(fā)者能夠使用 Hugging Face 平臺(tái)內(nèi)的 NVIDIA DGX? Cloud AI 超級(jí)計(jì)算為高級(jí) AI 模型進(jìn)行訓(xùn)練及調(diào)優(yōu),借助為智能聊天機(jī)器人、搜索、摘要等特定行業(yè)應(yīng)用的業(yè)務(wù)數(shù)據(jù)定制的大語(yǔ)言模型(LLM),推動(dòng)生成式 AI 在各個(gè)行業(yè)中的應(yīng)用。

黃仁勛表示:“Hugging Face 與 英偉達(dá)正在將全球最大的 AI 社區(qū)與英偉達(dá)在全球領(lǐng)先云環(huán)境中的AI計(jì)算平臺(tái)相連接。通過(guò)雙方的合作,Hugging Face 社區(qū)用戶只需要點(diǎn)擊一下鼠標(biāo),就可以使用 NVIDIA AI 計(jì)算。”

作為合作的一部分,Hugging Face 將提供一項(xiàng)名為“訓(xùn)練集群即服務(wù)”的新服務(wù),用以簡(jiǎn)化企業(yè)創(chuàng)建新的自定義生成式 AI 模型的過(guò)程。該服務(wù)由 NVIDIA DGX Cloud 提供支持,將在未來(lái)幾個(gè)月內(nèi)推出。

為可擴(kuò)展的開(kāi)放式3D世界生態(tài)系統(tǒng)通用場(chǎng)景描述提供加速,英偉達(dá)在會(huì)上還發(fā)布了3款適用于臺(tái)式工作站的GPU:RTX 5000、RTX 4500和RTX 4000。這些工作站級(jí)別的 GPU 采用第三代RT Core,其吞吐量高達(dá)上一代的2倍。這使得用戶能夠?qū)崟r(shí)處理更大且保真度更高的圖像。

英偉達(dá)針對(duì)企業(yè)客戶,還為去年發(fā)布的RTX 6000推出了最新的一站式解決方案RTX工作站。新的RTX工作站由英偉達(dá)和BOXX、戴爾科技、惠普和聯(lián)想合作推出,支持最多4張RTX 6000 GPU,可以在15小時(shí)內(nèi)完成8.6億token的GPT3-40B的微調(diào)。

在價(jià)格方面,RTX 5000 售價(jià) 4000 美元;RTX 4500 售價(jià) 2250 美元;RTX 4000 售價(jià) 1250 美元。目前,RTX 5000 已經(jīng)在 Leadtek、PNY 和 Ryoyo Electro 等合作伙伴處上市銷售,而其他兩款 GPU 以及搭載最多四塊 RTX 6000 GPU 的 NVIDIA RTX 工作站系統(tǒng)將在今年秋季推出。

英偉達(dá)此次深夜放大招,也被視為對(duì)競(jìng)爭(zhēng)對(duì)手AMD的反擊,此前英偉達(dá)曾預(yù)告將發(fā)布與AMD的大模型專用芯片Insight MI300X CPU + GPU競(jìng)爭(zhēng)的產(chǎn)品。

黃仁勛在演講中稱,“生成式 AI 時(shí)代和 AI 的 iPhone 時(shí)刻已經(jīng)到來(lái)”。對(duì)于英偉達(dá)來(lái)說(shuō),此次發(fā)布的GH200芯片及相應(yīng)平臺(tái),以及AI Workbench、工作站用GPU等,都將成為AIGC時(shí)代英偉達(dá)商業(yè)拓展之路前進(jìn)的一步。

猜你喜歡

“中國(guó)版英偉達(dá)”摩爾線程啟動(dòng)IPO,250億估值是“真金”還是“注水”?

國(guó)產(chǎn)GPU領(lǐng)域再傳喜訊,又一家實(shí)力企業(yè)準(zhǔn)備沖刺IPO了!

投中網(wǎng)

投中網(wǎng)

獵云網(wǎng)

獵云網(wǎng)

東四十條資本

東四十條資本

博望財(cái)經(jīng)

博望財(cái)經(jīng)